Por Àlex Ginés, BI & BA Business Manager

Continuamos la serie iniciada con el artículo “Cómo modernizar tu arquitectura de Business Intelligence con Data Lakehouse”.

En el anterior artículo hablamos de manera general de la arquitectura de datos que podríamos desplegar en Azure para analizar nuestros datos. Y bien, ¿por qué en Azure?

Como cualquier otro proveedor de cloud público, se dispone de servicios escalables para garantizar un rendimiento óptimo e intentar reducir los costes operativos. Pero no solo eso, sino que Microsoft está constantemente introduciendo nuevas características y servicios en Azure para ayudar a las organizaciones a mantenerse al día con las últimas tendencias y tecnologías en análisis de datos.

Es por eso por lo que desde ABAST creemos firmemente en el poder que tiene esta plataforma, no solo para desplegar soluciones IaaS, si no también PaaS, como es el caso que nos ocupa. Y a la vez, nos permite añadir o probar nuevas herramientas que van apareciendo en la plataforma cloud.

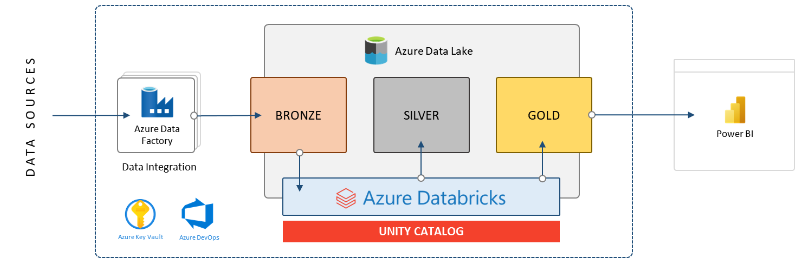

En el anterior artículo planteábamos la siguiente arquitectura para construir nuestro ecosistema de datos:

Hoy, vamos a hablar de las piezas que asientan nuestra arquitectura: Azure Data Factory, Azure Key Vault y Azure DevOps.

Azure Data Factory

En el artículo anterior, mencionábamos que Data Factory era el “integrador de datos de los orígenes al Data Lake”. Y esa es su función principal, conectarse a los orígenes de datos, sean del tipo que sean y volcar los datos en nuestro Data Lake. Pero para el caso que nos ocupa, no haremos ningún tipo de transformación ni manipulación, solo guardaremos los datos tal cual fueron creados en origen.

En la imagen a nuestra derecha se puede ver una muestra de los tipos de conectores que ofrece Data Factory de manera nativa. Y, adicionalmente, muchos más:

- Oracle

- Cualquier tipo de SQL Server

- Snowflake

- Dynamics

- Prácticamente cualquier servicio de Azure

- Muchos otros conectores para soluciones SaaS

A continuación, vemos un ejemplo de cómo se vería un flujo de copia de datos en Data Factory. En este caso, en primer lugar, copiamos todas las tablas que tengamos en la base de datos y las guardamos en un Data Lake. A continuación, iniciamos un Notebook de Databricks para realizar algunos trabajos adicionales (los detalles de esto los veremos en próximos artículos)

En ocasiones, Data Factory también puede funcionar como orquestador de datos. Esto es crear toda una serie secuencial o paralela de flujos de datos. Se le puede delegar este trabajo a Data Factory o realizarlo con otras herramientas como Databricks.

Azure Key Vault

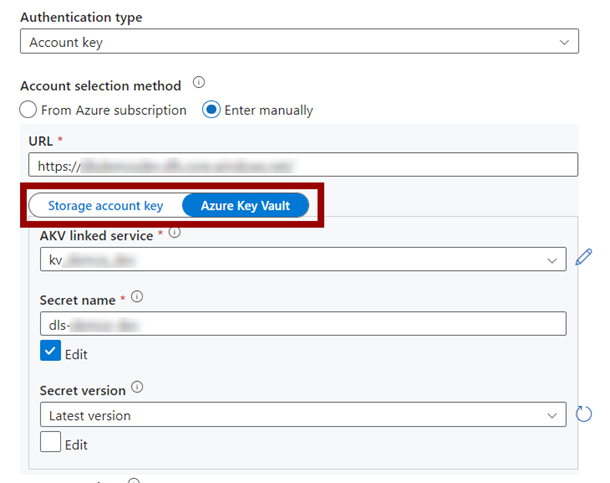

Cuando en Data Factory nos conectamos a los orígenes de datos, siempre necesitamos hacerlo con unas credenciales concretas. Por ejemplo, para volcar datos en nuestro Data Lake, Data Factory nos pide siempre un método de autenticación:

Esta autenticación puede realizarse a través de una “Storage account key”, que tendría que ser introducida a mano y cuando se renovara nos quedaríamos sin acceso y esto implicaría que todas las cargas fallarían. O, utilizando el servicio de “Azure Key Vault” que nos permite guardar secretos y contraseñas de manera segura y delegar la autenticación a todo el motor de seguridad embebido dentro de Azure.

Esto funciona dotando de permisos al servicio de Data Factory para que pueda leer los secretos que le pertenecen dentro de nuestro Key Vault.

Key Vault nos proporciona una gestión muy detallada de los permisos, asegurando que nuestras contraseñas y secretos estén siempre protegidos y nunca circulen en texto plano por la organización.

Azure DevOps

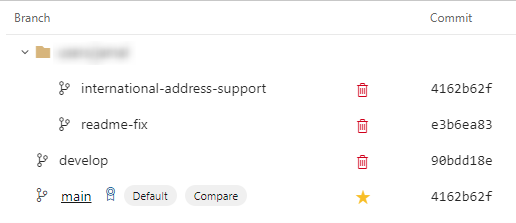

Los servicios que utilizaremos de Data Factory y Databricks se sustentan gracias al código que se crea por debajo de la aplicación. Esto quiere decir que todo lo que sea código es susceptible a pasar por un programa de control de versiones. Y en esencia, es lo que permite Azure DevOps, tener todo el control de versionado del código de la manera más cómoda posible gracias a Git:

Se puede realizar toda operación que esperaríamos de una herramienta así: pull requests, merges, commits, blames, etc.

No solo eso, si no que también nos permitiría poder gestionar el desarrollo del proyecto con la parte de organización de proyecto nativa de DevOps:

Y con estas tres piezas cerramos esta entrada. Más adelante profundizaremos en cómo se construye ese Lakehouse con las diferentes capas y su estructura, así como nos explayaremos en el funcionamiento de Azure Databricks y todas sus utilidades asociadas.

Si estás interesado en conocer más sobre las últimas tendencias en análisis de datos o si te gustaría probar la tecnología Data Lakehouse con un caso práctico, no dudes en ponerte en contacto con nosotros a través de nuestro formulario web.