Por Héctor Martínez,

Project Manager Database Solutions

Miembro del equipo Abast Innovation Lab

Estar a la última

El sector tecnológico es, sin duda, uno de los que ofrece un ritmo constante de novedades. Empujados por un potencial beneficio, es normal querer estudiar la adopción de la última tecnología emergente. El problema es decidir el momento adecuado para hacerlo.

El debate está entre llegar demasiado tarde, cuando su potencial como factor diferenciador, aunque sigue existiendo, se ha reducido, o llegar demasiado temprano, asumiendo costos extra en el proceso de maduración.

En 2004, se publicó un algoritmo que permitía buscar en datos no estructurados: MapReduce. Aunque en apenas cuatro años ya había aparecido Hadoop, fueron necesarios varios años más para que la palabra Big Data estuviera en la portada de todos los medios del sector y se popularizaran los despliegues. Ahora sabemos que muchos de estos proyectos se implementaron demasiado pronto. Hoy en día, la evolución de las tecnologías de Big Data continúa, pero con otros nombres (Spark) o enfoques diferentes (Databricks).

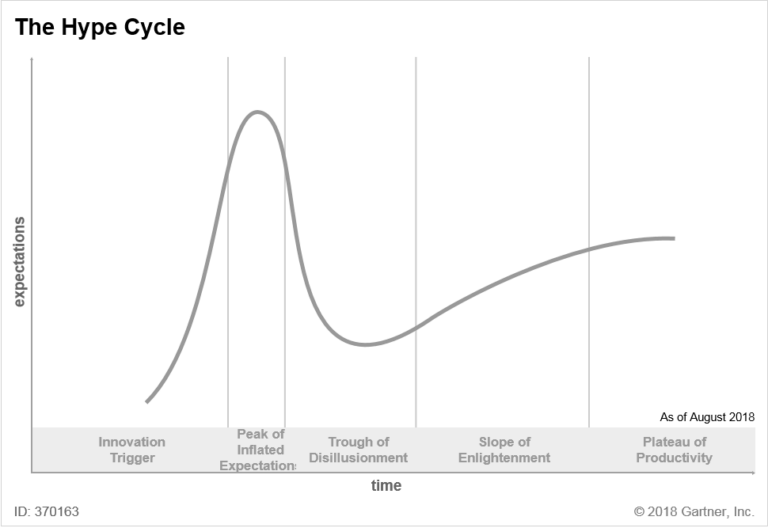

Este es un buen ejemplo de cómo una tecnología pasa por todas las fases de la curva del ciclo del «Hype» de Gartner: iniciada por una chispa de <Innovación>, seguida por unas <Expectativas Infladas> que claramente desembocan en <Desilusión>. Una vez pasada esa fase, se recupera el camino de <Iluminación> para llegar, finalmente, a la <Productividad>.

Un ejemplo actual

En 1946 se presentó ENIAC, uno de los primeros ordenadores de propósito general, utilizado por el Ejército de los EE.UU. para realizar cálculos balísticos. A principios de los años 80, se empezaron a implantar coprocesadores matemáticos junto a las CPUs de los ordenadores para ayudar en las operaciones de coma flotante. En los 2000, se había estabilizado la distribución de GPUs para ayudar con ciertos cálculos, tanto en videojuegos como en Inteligencia Artificial. En 2011 se vendió el primer ordenador cuántico comercial y, en 2021, Microsoft presentó Azure Quantum. Hoy en día se habla de los QCPUs (CPUs cuánticas) como acompañantes de las CPUs de propósito general en lo que llamaríamos Computación Cuántica Híbrida.

Los mayores ejemplos de uso de Computación Cuántica son los de optimización: gestión de flotas en empresas de logística, desarrollo de nuevos materiales para la industria, desarrollo de fármacos y detección de fraude para aseguradoras. Sin embargo, los dos sectores más prometedores son:

- Gestión de portafolios financieros.

- Eficiencia energética.

En 1973 se vivió un punto de inflexión con la introducción de las matemáticas en la gestión de derivados financieros, gracias al trabajo de Fischer Black y Myron Scholes. Myron Scholes ganaría años más tarde el Nobel de Economía. Con estos antecedentes, no era extraño que el sector financiero se fijara en la Computación Cuántica.

¿Debería entonces implementar la Computación Cuántica?

Preguntándole a mi hijo cuándo debemos implementar una nueva innovación tecnológica, su respuesta fue simple: «cuando la nueva sea mejor que la que tenemos». En este caso, tenemos una medida definida: la «Supremacía Cuántica«, que se alcanza cuando procesos que se realizan con computación clásica son más rápidos usando computación cuántica.

Lo que nos encontramos es que se anunció haber llegado a la Supremacía Cuántica en 2019, hace ya cinco años, en los cuales no hemos vivido ninguna revolución al respecto. Y es que, si ese fuese un <Desencadenante Innovador>, ahora estaríamos en la fase de <Desilusión>.

Hace cinco años ya hubo discusión sobre el anuncio de la Supremacía, pues algunos dudaban de la veracidad de esa afirmación, pensando que su objetivo era mantener la financiación de las investigaciones. Sin embargo, ha sido precisamente a partir de ese anuncio cuando los resultados en el sector de la Inteligencia Artificial han conseguido redirigir cualquier esfuerzo o inversión fuera del alcance de la computación cuántica.

Aunque el Quantum Roadmap se ha ido cumpliendo durante estos años, teniendo como próximo hito los más de 4000 qubits para 2025, hemos visto más señales de estancamiento. Si la computación funciona con bits, la computación cuántica funciona con qubits y la predicción es que hasta que no lleguemos al millón de qubits los ordenadores cuánticos no pasarán a la última fase de la curva de Gartner: la <Productividad>.

Lo cierto es que también hay una gran falta de algoritmos adaptados a la Computación Cuántica y capaces de sacar partido a todo su potencial, lo que limita enormemente los cálculos que podemos realizar y el despliegue y crecimiento de esta tecnología. Quizás por eso hay un gran esfuerzo en promover la Computación Cuántica en el ámbito universitario, como el Qiskit Summer School o el Quantum Challenge.

También existe una pugna por el lenguaje de desarrollo para computación cuántica, donde podemos encontrar Qiskit de código abierto, o Q#, el lenguaje de Microsoft, obligándonos a elegir como ya lo hacemos entre Java, C# o Python para nuestras aplicaciones. Pero la verdadera duda está en la arquitectura del hardware, donde no tenemos claro cuál es la mejor para fabricar qubits. Qubits Superconductores, Iones Atrapados o la apuesta de Microsoft con los Qubits Topológicos. Pero la verdad es que si quisiéramos apostar cuál será la mejor arquitectura de hardware necesitaríamos la fórmula de BlackScholes para reducir el riesgo.

¿Cuándo debo innovar entonces?

Para responder a esta pregunta es fundamental plantearse más cuestiones que nos ayuden a medir el momento adecuado para innovar, como: ¿Qué necesitamos para medir los tiempos de innovación? ¿Todos tenemos que innovar al mismo tiempo? ¿Qué factores definen el momento en el que debemos innovar?

No todas las organizaciones ni sectores se mueven al mismo ritmo, y aunque siempre exista el debate entre liderar o quedarse atrás, un buen análisis de la situación puede marcar el camino del éxito. Poner en valor el conocimiento de cada empresa junto a un buen acompañamiento, con visión de las tecnologías emergentes y los tiempos de innovación, puede ser la clave para responder a estas preguntas.